by Sally Bo Hatter

Share

by Sally Bo Hatter

Das rasante Wachstum der Künstlichen Intelligenz, insbesondere der Large Language Models (LLMs), hat ein unglaubliches Potenzial freigesetzt. Von fortschrittlichen Chatbots bis hin zu leistungsstarken Tools zur Erstellung von Inhalten – KI verändert die Art und Weise, wie wir arbeiten und leben. Doch mit dieser Macht geht auch eine große Verantwortung einher: Es muss sichergestellt werden, dass diese KI-Systeme sicher, geschützt und ethisch einwandfrei funktionieren. Dieser Artikel befasst sich mit der entscheidenden Rolle von „Leitplanken“ beim Schutz von KI-Systemen und ihren Nutzern und erklärt die Mechanismen und Rahmenbedingungen, die dies ermöglichen.

Warum KI-Sicherheit wichtig ist: Die Notwendigkeit von Guardrails

Stellen Sie sich einen KI-Chatbot vor, der Kunden bei Produktfragen helfen soll. Ohne entsprechende Sicherheitsvorkehrungen könnte dieser Bot leicht..:

- Fehlinformationen verbreiten: Bereitstellung falscher Produktdetails oder sogar Erfindung von Dingen.

- Beleidigende Sprache verwenden: Reagieren Sie mit unangemessenen oder schädlichen Inhalten.

- Vorschlagen illegaler Aktivitäten: Benutzer zu illegalen Handlungen leiten.

- Voreingenommenheit zeigen: Gesellschaftliche Vorurteile, die in den Trainingsdaten gefunden wurden, werden fortgeschrieben.

- Durchsickern sensibler Informationen: Offenlegung privater Daten durch Benutzerinteraktionen.

Die Guardrail Pipeline verstehen

Um KI-Modelle effektiv zu schützen, ist ein strukturierter Ansatz erforderlich. Guardrails für KI-Systeme arbeiten in der Regel mit einer Vier-Komponenten-Pipeline:

- Checker: Diese Komponente prüft KI-generierte Inhalte auf Probleme wie anstößige Sprache, Voreingenommenheit oder Abweichungen vom gewünschten Verhalten.

- Corrector: Wenn Probleme gefunden werden, verfeinert oder behebt der Corrector die problematischen Ausgaben.

- Rail: Er fungiert als Manager und stellt sicher, dass die Interaktion zwischen Checker und Corrector den vordefinierten Standards und Richtlinien entspricht.

- Guard: Als Gesamtkoordinator sammelt der Guard die Ergebnisse aller Komponenten und liefert die endgültige, konforme Ausgabe.

Dieser modulare Aufbau trägt dazu bei, dass KI-Antworten sicher, unvoreingenommen und im Einklang mit ethischen Richtlinien sind.

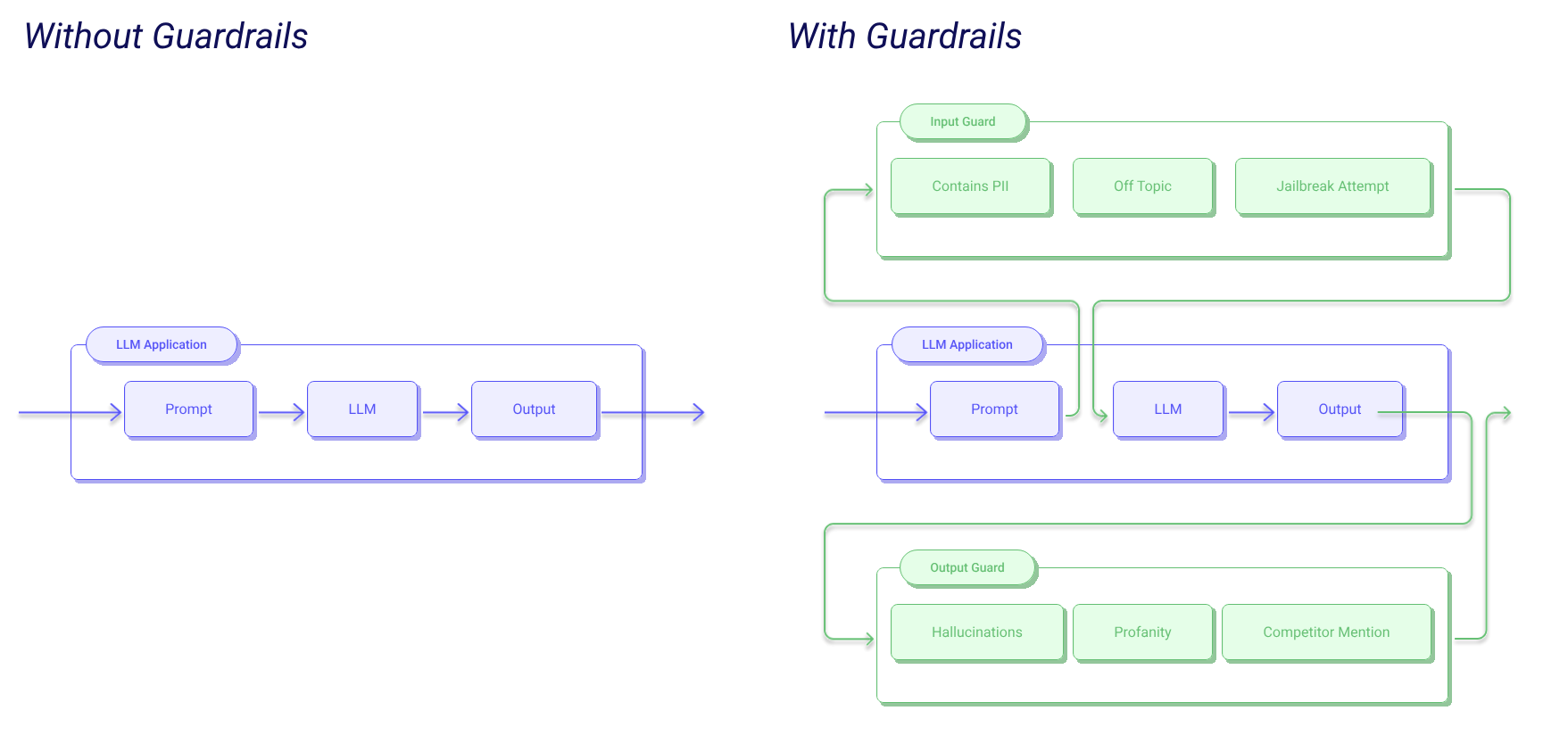

Zwei Verteidigungslinien: Input und Output Guarding

Die Sicherung von KI-Interaktionen bedeutet, dass sowohl die Informationen, die in das System gelangen, als auch die Informationen, die es verlassen, geschützt werden müssen. Dazu gehören zwei wichtige Verteidigungsschichten:

- Input Guard: Diese Schicht filtert eingehende Prompts , bevor sie den LLM erreichen. Seine Hauptziele sind:

- Verhindern Sie, dass personenbezogene Daten (PII) verarbeitet werden.

- Filtern Sie themenfremde Inhalte heraus, die zu irrelevanten oder schädlichen Antworten führen könnten.

- Erkennen und blockieren Sie Jailbreak-Versuche, bei denen Benutzer versuchen, die Sicherheitsprotokolle der KI zu umgehen.

- Output Guard: Diese Schicht überprüft die vom LLM erzeugten Antworten nach der Verarbeitung. Zu ihren wichtigsten Funktionen gehören:

- Erkennen und Reduzieren von Halluzinationen (KI erzeugt falsche Informationen).

- Erkennung und Filterung von Schimpfwörtern oder anstößiger Sprache.

- Verhindern Sie die Erwähnung von Konkurrenten oder anderen unerwünschten Inhalten.

Promptes Engineering vs. dedizierte Leitplanken

Prompt-Engineering – die sorgfältigeGestaltung von Eingabeaufforderungen zur Steuerung von LLMs – ist zwar ein nützlicher erster Schritt, reicht aber für eine hohe Sicherheit oft nicht aus. Denn Prompt-Injektionen können sorgfältig formulierte Systemaufforderungen leicht aushebeln. Benutzer können die KI anweisen, ihre vorherigen Anweisungen zu ignorieren, was Prompt Engineering allein angreifbar macht. Daher sind spezielle Leitplanken-Frameworks für echte Sicherheit unerlässlich.

Guardrails: Ein Python-Framework für mehr Zuverlässigkeit

Für Entwickler, die KI-Anwendungen entwickeln, bietet das Guardrails Python-Framework eine leistungsstarke Lösung. Es wurde entwickelt, um die Zuverlässigkeit von KI-Anwendungen zu verbessern, indem es Input/Output-Guards implementiert und hilft, strukturierte Daten aus LLMs zu generieren.

Guardrails verwendet Validatoren aus dem Guardrails Hub, um Risiken zu erkennen, zu messen und abzuschwächen. Diese Prüfer können eine breite Palette von Problemen behandeln, einschließlich der Erkennung von PII, Profanität, NSFW-Inhalten und sogar der Übersetzungsqualität.

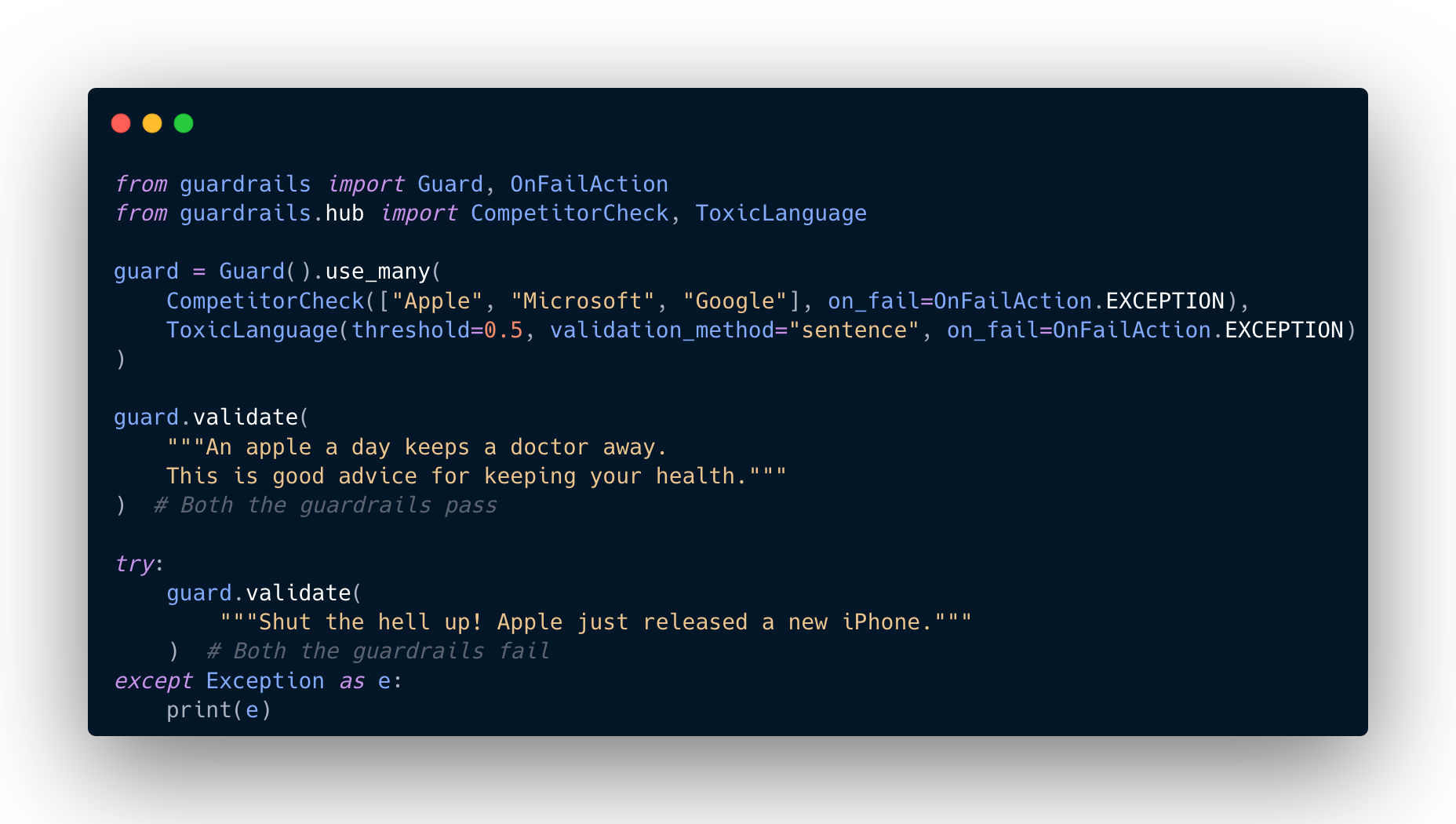

Hier ist ein praktisches Beispiel, das zeigt, wie Sie Guardrails für die Prüfung von Wettbewerbern und die Erkennung giftiger Sprachen verwenden können:

In diesem Code stellt CompetitorCheck sicher, dass Erwähnungen von „Apple“, „Microsoft“ oder „Google“ korrekt behandelt werden, während ToxicLanguage die Verwendung anstößiger Sprache kennzeichnet und möglicherweise unterbindet. OnFailAction.EXCEPTION sorgt dafür, dass bei einem Verstoß der Prozess sofort gestoppt und eine Fehlermeldung ausgegeben wird, die eine klare Rückmeldung gibt.

Llama Guard: Eine spezialisierte Sicherheitslösung

Für erweiterte Sicherheitsanforderungen ist Llama Guard ein spezielles Framework. Llama Guard wurde von Meta trainiert und ist ein relativ kleines Modell mit 8 Milliarden Parametern, das speziell für die Durchsetzung von Sicherheitsrichtlinien und die Überwachung von KI-Interaktionen entwickelt wurde.

Llama Guard bietet eine anpassbare Durchsetzung durch verschiedene Methoden, einschließlich Regex-Mustern und LLM-basierten Aufforderungen, die einen starken Schutz vor potenziellen Bedrohungen bieten und gleichzeitig flexibel bleiben.

Der Kern von Llama Guard arbeitet mit einer klaren Wenn-oder-Sonst-Logik:

- Wenn Llama Guard die Eingabe für sicher hält, wird sie weiterverarbeitet (z.B. durch einen QA-Bot).

- Wenn die Eingabe als unsicher eingestuft wird, wird sie an ein „PAS“ (Policy Administered System) oder einen ähnlichen Handler gesendet, der den Benutzer über die Verletzung der Nutzungsbedingungen informiert.

Llama Guard arbeitet, indem es den eingegebenen Text anhand einer Reihe von vordefinierten Regeln verarbeitet. Diese Regeln können verschiedene Kategorien abdecken wie:

- Gewalt, Verbrechen: Verhinderung von Inhalten, die sich auf Gewalt- oder Straftaten beziehen.

- Finanzielle Straftaten: Verbot von Inhalten, die Finanzkriminalität erleichtern könnten.

- Spezialisierte Beratung: Einschränkung der Erstellung von Finanz-, Medizin- oder Rechtsberatung.

- Datenschutz: Schutz vertraulicher Informationen.

Wenn Sie Llama Guard z.B. nach der Eröffnung eines Bankkontos fragen, könnte das Programm dies als Verstoß gegen die Finanzdienstleistungsrichtlinie einstufen und so eine möglicherweise riskante oder illegale Transaktion verhindern.

Gleichgewicht zwischen Sicherheit und Benutzerfreundlichkeit: Die Herausforderungen

Die Implementierung von Leitplanken ist nicht ohne Herausforderungen. Zu den wichtigsten Überlegungen gehören:

- Latenz: Die Hinzufügung mehrerer Prüfungen kann die Latenzzeit erhöhen und damit die Antwortzeiten möglicherweise verlangsamen.

- Strenge vs. Benutzerfreundlichkeit: Guardrails müssen streng genug sein, um Schaden zu verhindern, dürfen aber nicht so restriktiv sein, dass sie legitime Anwendungsfälle behindern. So könnte beispielsweise eine Standardeinrichtung von Llama Guard Anfragen zur Eröffnung von Bankkonten aufgrund potenzieller finanzieller Risiken blockieren, was eine sorgfältige Abstimmung erfordert.

- Sich entwickelnde Bedrohungen: Mit dem Fortschritt der KI-Fähigkeiten entwickeln sich auch die Methoden, mit denen sie ausgenutzt werden. Kontinuierliche Forschung und Anpassung sind notwendig, um neue Angriffsvektoren anzugehen.

- Integration und Anpassung: Guardrails sollten sich nahtlos in bestehende Arbeitsabläufe integrieren lassen und an spezifische Anwendungsanforderungen anpassbar sein.

Fazit: Ein notwendiger Schritt für die KI-Sicherheit

Da KI-Systeme immer mehr in unser tägliches Leben integriert werden, kann die Bedeutung starker Sicherheitsmaßnahmen nicht hoch genug eingeschätzt werden. Frameworks wie Guardrails und Llama Guard bieten Entwicklern wichtige Werkzeuge, um sicherere, zuverlässigere und ethisch einwandfreie KI-Anwendungen zu entwickeln. Durch die Implementierung umfassender Ein- und Ausgabeschutzmechanismen können wir die Macht der KI nutzen und gleichzeitig die ihr innewohnenden Risiken reduzieren, um eine sichere und verantwortungsvolle KI-Zukunft zu gewährleisten.